안녕하세요. 정글러입니다.

오픈AI에서 새로운 비디오 생성 모델 'Sora'를 공개했습니다.

text to video모델로 아직 일반 대중에게 공개하고 있진 않습니다.

이전에 DALLE나 Midjourney가 나왔을 때, 상상력의 영역은 넓혔지만 개인적으로는 실제로 영상에 활용하진 못했었는데요.

이번에 공개된 영상 예시를 보고 정말 놀랐습니다.

제작비 규모를 엄청나게 줄여줄 수 있는 획기적인 기술이라고 생각합니다.

1. 예시 영상

일본의 거리에서 촬영한 영화 장면같지만, 이 영상은 해당 프롬프트로 나온 영상입니다.

한 멋진 여성이 따스하게 빛나는 네온과 애니메이션으로 만들어진 도시 간판으로 가득한 도쿄의 거리를 걸어 내려갑니다. 그녀는 검은 가죽 재킷, 긴 빨간 드레스, 그리고 검은 부츠를 신고 검정 지갑을 가지고 갑니다. 그녀는 선글라스와 빨간 립스틱을 바꿉니다. 그녀는 자신감 넘치고 아무렇지도 않게 걷습니다. 그 거리는 축축하고 반사되어 다채로운 빛의 거울 효과를 만들어냅니다. 많은 행인들이 걸어 다닙니다.

A stylish woman walks down a Tokyo street filled with warm glowing neon and animated city signage. She wears a black leather jacket, a long red dress, and black boots, and carries a black purse. She wears sunglasses and red lipstick. She walks confidently and casually. The street is damp and reflective, creating a mirror effect of the colorful lights. Many pedestrians walk about.

정말 놀랍지 않나요?

사용자가 상상력을 발휘해 텍스트로 적어내려가는 대로 영상을 생성할 수 있습니다.

오픈 AI는 촬영에서 가장 중요한 요소인 빛을 정확하게 이해하고 영상을 생성하고 있습니다.

빨간 울 뜨개질 오토바이 헬멧을 쓰고 파란 하늘 소금 사막 시네마틱 스타일을 입은 30세 우주인의 모험을 담은 영화 예고편이 35mm 필름, 선명한 색상으로 촬영되었습니다.

A movie trailer featuring the adventures of the 30 year old space man wearing a red wool knitted motorcycle helmet, blue sky, salt desert, cinematic style, shot on 35mm film, vivid colors.

2. 개발 방법

OpenAI 홈페이지에 올라온 개발방법을 간단하게 요약해보겠습니다.

2.1) 시각적 데이터를 패치로 변환

Chat GPT가 대규모 언어 모델(LLM)에서 텍스트 토큰을 사용했다면, 소라에는 시각적 패치가 있습니다.

오픈 AI는 패치가 다양한 유형의 비디오와 이미지에 대한 생성 모델을 훈련하는 데 매우 효과적인 표현임을 발견했습니다.

2.2) 비디오 압축 네트워크

Sora는 시각적 데이터의 차원을 줄이는 네트워크를 훈련합니다. 이 네트워크는 비디오를 입력받아, 시간적으로나 공간적으로 압축된 잠재된 표현을 출력합니다. Sora는 이 압축된 잠재 공간에 대해 훈련하고 그 후에 이 압축된 잠재 공간 내에서 비디오를 생성합니다. 또한 생성된 잠재 공간을 픽셀 공간에 다시 매핑하는 디코더 모델을 훈련합니다.

2.3) 스케일링 변환기

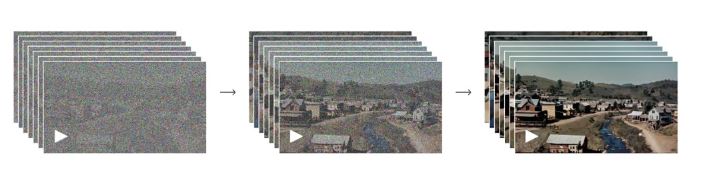

소라는 확산 변환기(diffusion transfomer)모델입니다.

위의 사진과 같이 노이즈가 있는 패치를 입력받았을 경우, '깨끗한' 패치를 예측하도록 훈련됩니다.

Sora는 ChatGPT의 핵심인 언어 이해 능력과 DALL-E를 통해 얻은 이미지 생성 노하우를 활용하여

실제로 촬영하면 제작비와 인건비가 엄청나게 들어가는 영상을 구현해냈습니다.

https://openai.com/research/video-generation-models-as-world-simulators

Video generation models as world simulators

We explore large-scale training of generative models on video data. Specifically, we train text-conditional diffusion models jointly on videos and images of variable durations, resolutions and aspect ratios. We leverage a transformer architecture that oper

openai.com

여기 더 자세한 정보가 나와있습니다.

3. 마치며

The NewYork Times는 DALL-E, Midjourney 등의 AI 이미지 생성이 사진과 거의 구별할 수 없는 이미지를 생성하고 있다고 말했습니다. 이로 인해 온라인에서 허위 정보를 식별하는 것이 더 어려워졌고, 많은 디지털 아티스트들은 이로 인해 작업을 찾는 것이 더 어려워졌다고 우려합니다.

https://www.nytimes.com/2024/02/15/technology/openai-sora-videos.html

OpenAI Unveils A.I. That Instantly Generates Eye-Popping Videos

The start-up is sharing the new technology, called Sora, with a small group of early testers as it tries to understand the potential dangers.

www.nytimes.com

이제 인류는 호모사피엔스에서 호모프롬프트로 진화하고 있습니다.

프롬프트(지시. 명령어)를 입력하며 AI를 활용하는 인간이라는 뜻입니다.

Sora 역시, 이를 이용하기 위해선 '어떻게 지시하고, 상상하는지'가 중요한 역량이 되었습니다.

뉴욕타임즈가 비판한 것과 같이, 허위 정보를 생성하기 더욱 쉬워졌고 영상제작자들의 일자리가 위험하지만 영상 업계에 종사하고 있는 저 역시, 외면하기엔 어려운 기술력인 것 같습니다.

이를 제대로 활용하면 무한의 상상력을 펼쳐 퀄리티 높은 영상을 활용할 수 있을 것 같습니다.

감사합니다:)

'AI > AI model' 카테고리의 다른 글

| [Stable Diffusion] MAC에 스테이블 디퓨전 웹UI 설치하기 (0) | 2024.04.16 |

|---|---|

| [Top 100 AI] AI 소비자 어플 top100 알아보기 (0) | 2024.03.27 |

| [DUSt3R] Image to 3D, 네이버랩스 (0) | 2024.03.26 |

| [LATTE3D] 엔비디아 3D그래픽 구현 생성형 AI 모델 (0) | 2024.03.26 |

| [Luma] 3D 모델링 만들어보기 (0) | 2024.02.29 |