안녕하세요. 정글러입니다.

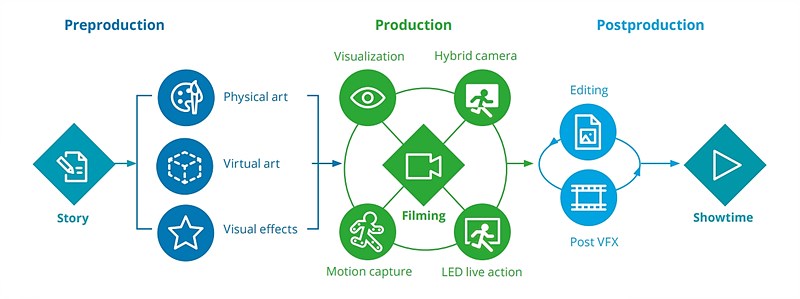

오늘은 Virtual Production에서 어떠한 기술을 사용하고 있고, 어떻게 활용될 수 있는지 알아보겠습니다.

1. Lighting

현실감 있는 공간 연출

-

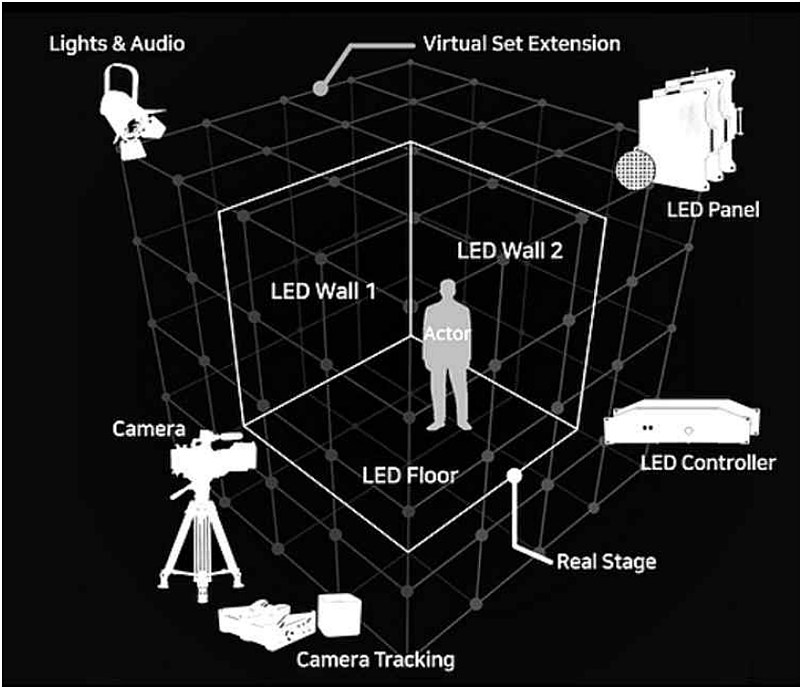

LED 화면을 활용하면 배경, 세계, 환경을 구현할 수 있을 뿐만 아니라 환경 조명까지 제공하여 현실적이고 합리적인 결과물을 얻을 수 있습니다.

-

기존의 그린스크린보다 훨씬 더 효율적으로 환경을 반영할 수 있는 조명이 가능하고, 현장에서 lighting set을 처리함으로써 현실성 있는 결과물을 만들어냅니다.

-

이러한 기술로 배우나 물건을 구별할 필요 없이 필요한 월드를 보여주거나, 차량 촬영 시 산이 지나가는 풍경을 켤 수 있습니다.

-

LED 화면에서 빛을 활용한 반사 효과로 더욱 아름답고 현실적인 이미지를 제공하며 실루엣 및 물체의 반사를 재현합니다.

2. Tracking

센서가 설치된 카메라를 통해 언리얼엔진과 동기화 / Vicon을 사용

천장에 부탁된 마커가 카메라를 인지한다.

- 퍼포먼스 캡처; 자오로스코스 센서로 감지해난 뒤 디지털화 (모션캡처, 볼륨메트릭 캡처)

-

모션 캡처 슈트를 입고 풀 바디 추적하여 실제 모션과 함께 모니터링이 가능합니다.

-

모션 캡처와 함께 언리얼 엔진 내의 physical prop 요소도 추적하여 촬영에 활용합니다.

-

화면을 통해 실시간으로 확인해가며 성능 수준 높이며 퍼포먼스에 따라 새로운 아이디어 발전 시도할 수 있습니다.

3. Simulcam

-

Simulcam은 영화 제작자들이 실시간으로 3D CGI 자산과 상호작용할 수 있도록 돕는 솔루션입니다.

-

기존엔 3D CGI 자산은 후반 제작 단계에서 시각 효과 합성물로 추가되지만, Simulcam은 이를 실제 제작 단계로 실시간으로 가져옵니다.

-

실제 배우가 가상 객체 또는 가상 캐릭터와 상호작용해야 할 때, Simulcam은 리얼타임으로 씬을 보여줍니다.

4. In-Camera Effects

- 언리얼 엔진 내의 카메라

- LiveLinkLens 플러그인을 통해 언리얼엔진 내에 카메라를 연결할 수 있습니다.

- 현재 많은 콘텐츠를 카메라에서 촬영하고, 감독과 디렉터 오브 포토그래피가 화면에 이르기까지 사용할 수 있으므로 VFX 산업에 매우 유용합니다.

- 이렇게 하면 환경을 더 잘 표현할 수 있으며, 배우들이 이미 해당 공간에 있기 때문에 더 실감이 납니다.

- LED 스크린을 사용하면 자연스러운 조명 효과를 얻을 수 있어 그린 스크린보다 이점이 많습니다.

-

포스트 프로덕션에서의 추가 작업이 필요없으며, 자연스러운 조명 효과를 얻을 수 있습니다.

4. Scanning

- 최근 AI NeRF기술을 활용하여 가장 효과적으로 할 수 있는 영역

https://www.youtube.com/watch?v=GMvK4AkVizw&list=PL9B1Myj5eWt8-z1pd-vSD8y7JAm_1P1nD&index=5

-

영상촬영 대신 리츠호텔을 스캔한 이유: 다양한 조명 상태에서 자유롭게 활용가능하며 실제 현장 거리를 방해하지 않습니다.

-

LiDAR 기술을 사용하여 정밀한 3D 모델을 얻음. 레이저를 회전시켜 거리를 측정하고, 포토그램메트리 기술로 텍스처를 채워감. 다수 카메라를 사용하여 데이터 획득에 중점을 둡니다.

-

Reality Capture 프로그램으로 이미지와 LiDAR 데이터를 정렬하고 모델로 변환, 이후 3D 애플리케이션인 3D 스튜디오 맥스를 활용하여 더욱 단순하고 정교한 모델로 재창조 합니다.

-

텍스처를 반복하는 과정을 거쳐 최종 결과물을 얻음. 셀프 프로젝트를 통해 섬세하고 고급스러운 모형을 재현합니다.

추가로 최근에 Volinga라는 기업에서는 루마에서 만들어진 3D스캔본의 부족한 부분을 색칠하면 자동으로 채워주는 기술을 선보였더라고요.

핸드폰에서 AI를 활용해서 사람을 지우는 것처럼, LiDAR카메라가 인식하지 못한 부분을 채워주니, 앞으로는 더 손쉽게 3D월드 모델을 만들 수 있을 것 같습니다.

5. 360 Photospheres

-

360도 포토 스피어는 고해상도의 사진 파노라마

- 그러나 여전히 2차원 이미지이기 때문에 카메라 위치 변화에 따른 배경의 움직임이 반영되지 않고, 거리가 먼 배경에 더 어울리는 경향이 있습니다.

- 월드를 재창조할 필요 없이 현실을 담아내는 사진기술인 포토 스피어는 시간을 절약하면서도 현실감을 높일 수 있습니다.

https://youtube.com/playlist?list=PL9B1Myj5eWt8-z1pd-vSD8y7JAm_1P1nD&si=rccrU4NGwQHRoqWv

*해당 시리즈를 참고하였습니다.

국내에서는 그동안 유니티를 주로 사용했지만, 이제는 게임, 영화 등의 현장에서는 언리얼엔진으로 바뀌고 있는 것 같습니다.

이제 언리얼엔진의 성능이 더욱 좋아지고, 또 AI를 통한 월드제작 작업이 쉬워졌으니, 기존엔 게임이나 영화에서만 자주 활용했던 해당 기술을 방송이나 광고뿐만 아니라 개인 제작자도 쉽게 활용하는 날이 오지 않을까 생각해봅니다.

메타버스 Campus > 교육신청 > 해외선진기술 도입 교육

해외선진기술 도입 교육

www.metaverse-campus.kr

이번에 메타버스Campus에서 NeRF를 활용한 3D Reconstruction 기술 교육을 한다고 합니다.

저는 온라인으로 참여하려고요. 관심있으신 분들 신청해보세요!

감사합니다.

'XR > Unreal Engine' 카테고리의 다른 글

| [Unreal Engine] 블루프린트와 나이아가라 알아보기 (1) | 2024.06.03 |

|---|---|

| [Virtual Production] 언리얼엔진 내 Visualization 살펴보기 (0) | 2024.05.13 |

| [Unreal Engine] 라이트 세팅 알아보기 (1) | 2024.05.09 |

| [Unreal Engine] Player Controller 블루프린트 이해하기/ 시작해요 언리얼2024 등록 (0) | 2024.04.29 |

| [Blender] 블렌더(blender) 4.0의 새로운 기능 (0) | 2024.03.07 |